Pengantar: Era Data Besar dan Pentingnya Arsitektur

Di era digital, volume data yang dihasilkan terus meningkat dengan kecepatan yang luar biasa. Dari media sosial hingga sensor IoT, berbagai sumber menghasilkan data dalam jumlah besar yang sering kali sulit dikelola tanpa kerangka kerja yang tepat. Big Data Architecture and Infrastructure adalah solusi untuk tantangan ini, memungkinkan organisasi untuk menyimpan, mengolah, dan menganalisis data dengan efisien.

Arsitektur big data memberikan fondasi bagi pengelolaan data besar secara terstruktur, sementara infrastruktur mendukung operasionalisasi teknologi tersebut. Kombinasi keduanya memungkinkan perusahaan mengambil keputusan berbasis data secara real-time, memperbaiki proses bisnis, dan meningkatkan daya saing.

Apa Itu Big Data Architecture and Infrastructure?

Big Data Architecture adalah desain sistem yang mencakup perangkat lunak, perangkat keras, dan teknologi untuk mengelola data besar. Infrastruktur, di sisi lain, terdiri dari elemen fisik dan virtual seperti server, jaringan, serta layanan cloud yang mendukung penyimpanan dan pemrosesan data besar.

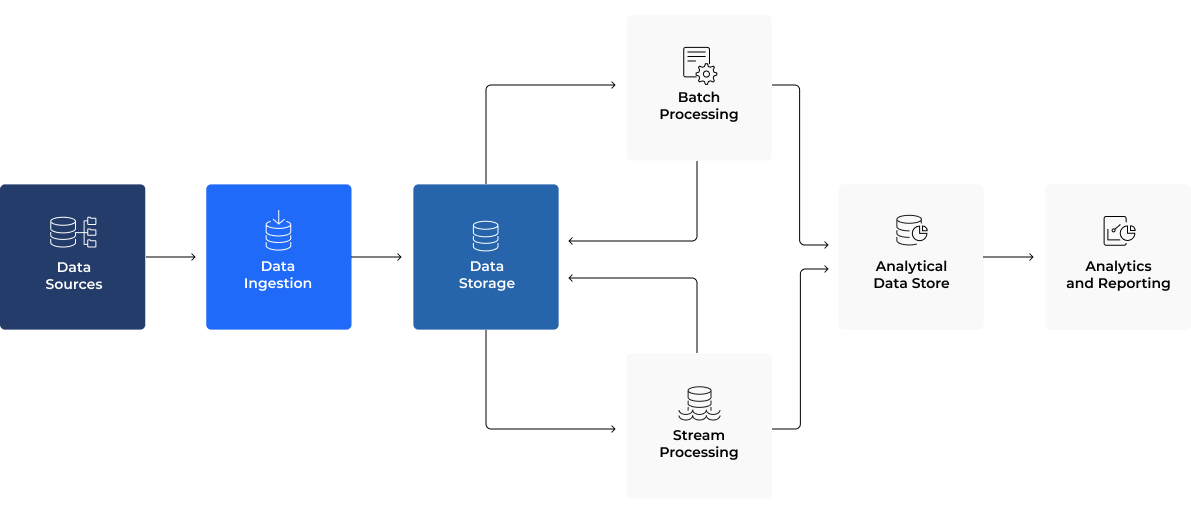

Komponen Utama Big Data Architecture:

- Sumber Data

Data berasal dari berbagai sumber seperti perangkat IoT, media sosial, basis data perusahaan, dan aplikasi web. - Ingestion (Pengumpulan Data)

Proses ini melibatkan alat seperti Apache Kafka dan AWS Kinesis untuk membawa data ke sistem. - Penyimpanan

Sistem penyimpanan yang dapat diskalakan seperti Hadoop Distributed File System (HDFS) atau AWS S3 digunakan untuk menyimpan data mentah dan terstruktur. - Pemrosesan

Framework seperti Apache Spark digunakan untuk pemrosesan batch, sementara Apache Flink menangani analitik real-time. - Analitik dan Visualisasi

Alat seperti Tableau, Power BI, atau Apache Superset digunakan untuk menganalisis data dan menyajikannya dalam bentuk yang mudah dipahami.

Manfaat Big Data Architecture and Infrastructure

- Efisiensi Operasional

Dengan desain yang tepat, perusahaan dapat mengolah data besar secara efisien dan mengurangi waktu pemrosesan. - Analitik Real-Time

Organisasi dapat membuat keputusan yang lebih cepat dengan analisis data secara real-time. - Pengurangan Biaya

Dengan memanfaatkan layanan cloud, organisasi dapat mengurangi kebutuhan investasi dalam perangkat keras fisik. - Peningkatan Skalabilitas

Infrastruktur big data dapat diperluas untuk menangani volume data yang terus meningkat tanpa memengaruhi kinerja.

Teknologi Inti dalam Infrastruktur Big Data

Cloud Computing

Teknologi komputasi awan seperti AWS, Google Cloud, dan Microsoft Azure memberikan skalabilitas dan fleksibilitas. Perusahaan dapat menyimpan data tanpa batasan ruang fisik dan hanya membayar berdasarkan pemakaian.

Distributed Computing

Sistem seperti Apache Hadoop memungkinkan pemrosesan data yang besar dengan mendistribusikannya ke beberapa node atau server.

Data Lakes dan Warehouses

- Data Lake: Penyimpanan untuk data mentah dari berbagai format. Contoh: AWS Lake Formation.

- Data Warehouse: Penyimpanan data yang terstruktur untuk keperluan analitik. Contoh: Snowflake.

Container dan Orkestrasi

Teknologi seperti Docker dan Kubernetes mempermudah pengelolaan aplikasi big data, memberikan efisiensi dalam pengembangan dan deployment.

Tantangan dalam Membangun Big Data Architecture

- Data Silos

Data yang terisolasi di berbagai departemen menyulitkan analisis holistik. Solusinya adalah mengintegrasikan data ke dalam satu platform. - Kompleksitas Teknis

Infrastruktur big data membutuhkan keahlian khusus untuk mengelola berbagai alat dan teknologi yang digunakan. - Biaya Operasional

Meski solusi cloud mengurangi investasi awal, biaya penggunaan jangka panjang harus diperhitungkan dengan hati-hati. - Keamanan Data

Melindungi data dari ancaman keamanan siber adalah tantangan utama. Adopsi teknologi seperti enkripsi dan autentikasi dua faktor menjadi langkah penting.

Tren Masa Depan Big Data Architecture and Infrastructure

- Integrasi dengan Kecerdasan Buatan (AI)

AI akan semakin berperan dalam mengotomatisasi proses analitik, mempercepat pemrosesan, dan memberikan wawasan yang lebih akurat. - Edge Computing

Pemrosesan data akan dilakukan lebih dekat ke sumbernya, mengurangi latensi dan mempercepat analitik. - Arsitektur Tanpa Server (Serverless)

Model ini menghilangkan kebutuhan untuk mengelola server, memungkinkan pengembang fokus pada pengembangan aplikasi. - Blockchain

Teknologi ini akan meningkatkan keamanan data dengan menyediakan catatan yang transparan dan tidak dapat diubah.

Langkah-Langkah Implementasi Big Data Architecture yang Efektif

Langkah-Langkah Implementasi Big Data Architecture yang Efektif

- Identifikasi Kebutuhan Bisnis

Memahami kebutuhan spesifik perusahaan untuk memilih teknologi yang sesuai. - Pilih Platform yang Tepat

Tentukan apakah menggunakan solusi on-premise, cloud, atau hybrid. - Pastikan Kepatuhan Data

Terapkan kebijakan untuk mematuhi regulasi seperti GDPR atau CCPA. - Investasi pada Pelatihan Tim

Pastikan tim memiliki pengetahuan yang cukup untuk mengelola sistem yang kompleks.

Studi Kasus: Implementasi Big Data dalam Perusahaan

Perusahaan e-commerce besar mengadopsi Big Data Architecture untuk menganalisis pola pembelian pelanggan. Dengan memanfaatkan Hadoop dan Tableau, mereka mampu:

- Memahami preferensi pelanggan secara lebih baik.

- Memprediksi permintaan produk di masa depan.

- Mengoptimalkan inventaris untuk mengurangi biaya penyimpanan.

Hasilnya, mereka meningkatkan pendapatan hingga 20% hanya dalam waktu setahun.

Kesimpulan

Big Data Architecture and Infrastructure adalah fondasi dari era data modern. Dengan mengadopsi kerangka kerja yang kuat dan infrastruktur yang andal, organisasi dapat memanfaatkan kekuatan data untuk mencapai tujuan bisnis mereka. Di tengah persaingan yang semakin ketat, investasi dalam big data adalah langkah strategis untuk memastikan keberlanjutan dan kesuksesan di masa depan.

#Analitik Data #Apache Spark #big data #Big Data Architecture #Blockchain #cloud computing #Data Lake #Data Warehouse #Distributed Computing #Edge Computing #Hadoop #Infrastruktur Big Data #iot #keamanan data #kecerdasan buatan #Kubernetes #Pemrosesan Data Real-Time #Pengolahan Data Besar #Tableau #Teknologi Big Data